Dalla Privacy al lavoro, e poi nell’Automazione, nella salute, nelle applicazioni e nei servizi Smart, in politica, nel marketing e in molto altro ancora: lo sviluppo impetuoso dell’Intelligenza artificiale apre importanti questioni etiche in molti settori, in molte attività quotidiane.

Con incognite su come procedere, come programmare tutta questa Artificial intelligence (AI), come affrontare i cambiamenti in atto, punti interrogativi a cui, da più parti, servono risposte adeguate ma complesse.

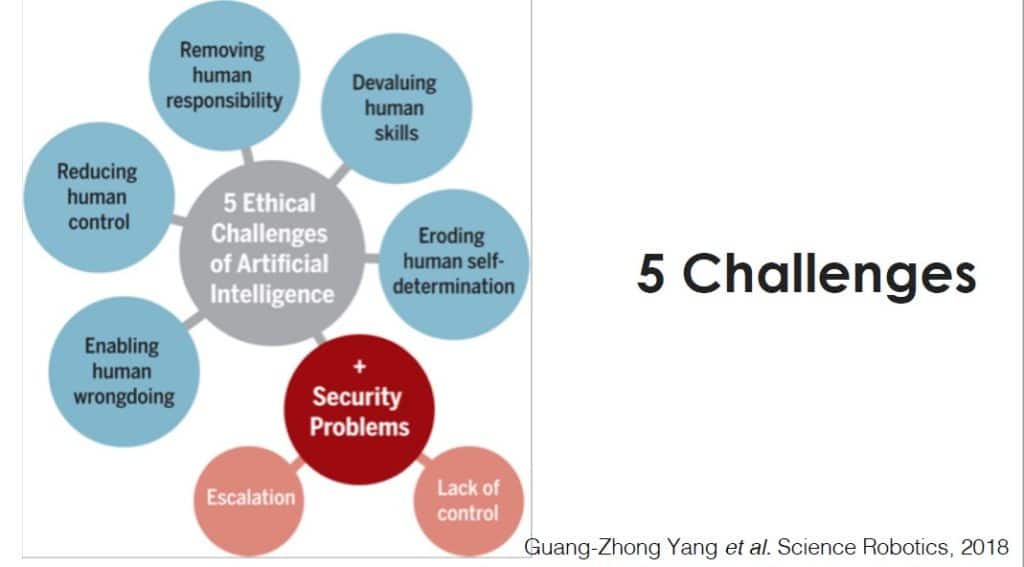

Sono cinque, secondo diversi studiosi, tra sociologi ed esperti di Digital transformation, le principali sfide etiche poste dall’Intelligenza artificiale, da affrontare e risolvere. Riguardano il rapporto tra fiducia e controllo nel rapporto tra Uomo e AI; il cambiamento dei profili di responsabilità e la ‘sostituzione’ dell’attività umana con l’AI; il rischio di erodere l’autodeterminazione umana e il suo “libero arbitrio”; il rischio di svalutazione delle competenze e delle capacità umane; il rischio di replicare non solo le qualità, ma anche errori e difetti dell’agire umano.

Fattori diversi, ma strettamente intrecciati tra loro, nella grande matassa, tutta da sbrogliare, rappresentata dalle enormi opportunità ma anche dai rischi collegati alle applicazioni di un’Artificial intelligence sempre più potente e pervasiva.

“Le nuove tecnologie aprono scenari immaginifici e sorprendenti, ma, se non sono governate in modo adeguato, rischiano di portare effetti indesiderati, altrettanto sorprendenti ma in senso negativo”, osserva Mariarosaria Taddeo, filosofa dell’Università di Oxford e dell’Alan Turing Institute di Londra.

La docente universitaria italiana che vive e lavora in Gran Bretagna, come altri studiosi e specialisti dei fenomeni e delle tendenze collegate all’innovazione digitale, quindi rimarca e mette in evidenza le “cinque sfide etiche per l’Intelligenza artificiale” da vincere, per evitare di ritrovarsi con una tecnologia controproducente, gestita male o fuori controllo.

Indice degli argomenti

Uomo e AI, fiducia versus controllo

Uno dei principali nodi da sciogliere, nel rapporto tra Uomo e Intelligenza artificiale, riguarda il fatto di determinare il livello di fiducia con cui delegare alla Macchina certe operazioni, e, in maniera complementare e speculare, il livello di controllo da mantenere tra le mani per verificare come sta funzionando questa intelligenza ‘programmata’. Un aspetto tanto più delicato quanto più aumenta la posta in gioco.

“Teniamo sempre bene presente che l’Intelligenza artificiale non ha idee, intuizioni, sentimenti, ma è l’esecuzione di un compito che, se l’avesse fatto un essere umano, sarebbe considerato intelligente”, fa notare Taddeo. Che rileva: “più riduciamo il controllo umano, più dobbiamo aumentare il livello di fiducia verso l’AI. Fino a che punto? Considerando che è sempre più difficile, dato un certo Input, prevederne l’Output, prevederne gli effetti”.

Sostituzione dell’attività umana e responsabilità

Con la crescente diffusione delle applicazioni di Artificial intelligence, destinata a moltiplicarsi, un altro degli effetti più immediati riguarda la sempre maggiore sostituzione dell’attività umana con l’AI. E quindi anche la ‘rimozione’ della responsabilità umana, che passa in misura sempre più consistente sul lato Macchina.

Ma se qualcosa non funziona o va storto, la responsabilità di chi è? Di chi ha programmato il sistema di Intelligenza artificiale? Di chi l’ha prodotto? Del proprietario? Incognite molto delicate e che attendono soluzioni non facili da definire, soprattutto a livello internazionale, dove misure e normative possono essere molto diverse tra loro.

Chi decide e chi non deve prendere decisioni

“Un altro effetto sensibile dell’evoluzione in corso riguarda, poi, il rischio di erodere l’autodeterminazione umana e la possibilità di decidere da parte dell’Uomo”, sottolinea la docente italiana di filosofa all’Università di Oxford. Una conseguenza strettamente collegata al livello di fiducia e di delega che l’essere umano può trasferire sui sistemi tecnologici, con il rischio però di rimanere tagliato fuori dalle decisioni che poi l’AI potrà prendere in autonomia e in modo automatico, diretto, senza bisogno dell’intervento umano.

L’Artificial intelligence, nelle sue varie forme, sta diventando un ‘mediatore’ Hi-tech sempre più diffuso e invisibile per le nostre scelte, decisioni e attività. Basti pensare, ad esempio, ai sistemi di domotica e agli assistenti vocali ‘intelligenti’, che regolano certe funzioni della casa e degli edifici, come illuminazione e riscaldamento, anche in base a parametri pre-impostati.

Anche qui, bisogna, da parte dei legislatori, tecnologi, esperti in materia, tracciare il sottile confine che separa la praticità e l’utilità di affidare a un sistema ‘Smart’ compiti e funzioni, con l’effetto controproducente di perdere il controllo di azioni e operazioni.

Il rischio di svalutare o perdere le competenze

Più aumentano i livelli di automazione, fiducia e delega nei confronti dell’Artificial intelligence, più cresce la possibilità che, soprattutto nel lungo periodo, si possano svalutare o anche perdere delle competenze e capacità umane, che non vengono più utilizzate come un tempo perché rimpiazzate da quelle tecnologiche.

Questo è il classico caso in cui l’automazione e l’Intelligenza artificiale possono sostituire l’Uomo nelle attività di lavoro, per cui, oltre a rendere obsolete certe mansioni, in altri casi possono ridurre l’importanza delle competenze umane, fino al rischio che vengano perse perché poco o non più utilizzate, e non più trasmesse da lavoratore a lavoratore.

Evitare di replicare errori e difetti dell’Uomo

I programmatori dei sistemi di Intelligenza artificiale sono uomini e donne in carne e ossa, a parte naturalmente le applicazioni di Machine learning che ‘imparano’ direttamente dai dati disponibili e altre istruzioni automatizzate. Quindi un altro rischio da tenere presente e scongiurare riguarda la possibilità che errori e difetti dell’agire umano possano essere trasferiti, volutamente e non, alle Macchine e ai computer.

È il caso, ad esempio, di fenomeni di discriminazione, di razza, genere, religione, o altro ancora: se il sistema di AI ha ricevuto determinati Input e istruzioni, li applicherà senza filtri etici, legali o morali. Per questo, questi filtri, linee guida, spartiacque tra il virtuoso e il rovinoso, restano a capo degli individui in carne e ossa.

La tecnologia, di per sé, non è né buona né cattiva. La differenza sta in come viene utilizzata dall’Uomo. Per questo, quando si considerano le sfide etiche da affrontare nel campo dell’Intelligenza artificiale, e dell’Hi-tech più in generale, si può fare riferimento e ricordare anche il manifesto di Bertrand Russell e Albert Einstein, del 1955, contro la minaccia nucleare, sottoscritto da una dozzina di premi Nobel dell’epoca, che metteva la questione etica al centro di ogni sviluppo tecnologico.

Il nuovo corso di Etica del Politecnico di Milano

Per tutti questi motivi e necessità, in modo pioneristico nel panorama accademico italiano, il Politecnico di Milano ha attivato il primo corso universitario di ‘Ethics for Technology‘, Etica per la tecnologia, rivolto a studenti dei diversi corsi di Ingegneria. Un insegnamento inedito, ma significativo dei cambiamenti in atto, che punta alla formazione di futuri ingegneri consapevoli degli impatti etici della progettazione ingegneristica, e capaci di orientarla fin dall’inizio verso un’innovazione tecnologica responsabile.

“Ogni innovazione porta con sé dei rischi, ma non per questo ci spaventiamo, né queste prospettive devono spaventare il progettista e il programmatore, né per questo siamo pessimisti sul futuro”, rimarca il rettore del Politecnico milanese, Ferruccio Resta.

Che spiega: “è un dovere per un’università tecnica, tra le prime in Europa per livello della formazione, affrontare il cambiamento introdotto dalle nuove tecnologie partendo dall’etica, da un punto di osservazione privilegiato che integra gli aspetti ingegneristici e progettuali con il pensiero filosofico e l’analisi sociologica. La pervasività della tecnologia, le risposte che promette di dare, le scelte che sempre di più vengono demandate agli algoritmi, evidenziano come sia necessario comprenderne appieno potenzialità e rischi, e partire dalla formazione per una nuova etica della responsabilità”.

Etica e Hi-tech, qualcosa si muove

Ma, oltre che i singoli individui, la gestione e il governo del mondo digitale e dell’Intelligenza artificiale riguardano scenari molto più grandi. In Italia, tra fine 2018 e l’inizio di quest’anno, il Ministero dello Sviluppo Economico ha formato e reso operativa la ‘squadra’ di professionisti ed esperti che collaboreranno con il Ministero e il Governo per elaborare la strategia nazionale sull’Intelligenza artificiale, insieme all’analogo Team in materia di tecnologie Blockchain.

A livello europeo, con il lavoro del Gruppo di Alto livello nominato dalla Commissione Ue, lo scorso 18 dicembre è stata resa nota la prima bozza delle ‘Ethic Guidelines fo Trustworthy AI‘, le nuove linee guida del codice etico per l’Intelligenza artificiale, che dovrebbero essere adottate entro questo mese di marzo. L’obiettivo è fornire un quadro di regole a livello etico per fare in modo che un sistema di Intelligenza artificiale sia “affidabile”, secondo una visione umano-centrica e dei diritti fondamentali dell’Uomo. Trattandosi di linee guida etiche, non avranno efficacia vincolante per i Paesi dell’Unione Europea.

Il documento assumerà però importanza nel momento in cui si dovranno adottare delle scelte di politica legislativa all’interno dell’Unione sul tema dell’intelligenza artificiale, come ad esempio le responsabilità collegate al suo uso e i diritti dei cittadini.